Как мы заменили сценарного робота

на понимающего живую речь AI-ассистента

Рассказываем, как наш Заказчик готовится снизить нагрузку на консультантов и кардинально улучшить клиентский сервис

с помощью нового AI-помощника

Проблема / Вызов

На сайте Заказчика работал чат-бот. Но вместо того чтобы помогать, часто становился цифровым барьером. Это был классический сценарный бот, который мог вести пользователя только по жестко прописанным веткам диалога с помощью кнопок.

Основные болевые точки:

- Отсутствие гибкости: Если вопрос пользователя был сформулирован чуть иначе или не вписывался в сценарий, бот заходил в тупик с ответом "Я вас не понимаю".

- Негативный пользовательский опыт: Предприниматели, люди с дефицитом времени, были вынуждены прерывать бесполезный диалог и либо звонить Заказчику, либо самостоятельно искать информацию на сайте.

- Повышенная нагрузка на персонал: Вместо того чтобы автоматизировать рутину, старый бот фактически генерировал дополнительную работу для менеджеров, которым приходилось отвечать на одни и те же вопросы от разочарованных пользователей.

- Нулевая проактивность: Бот не мог анализировать запрос и предлагать релевантные услуги или мероприятия, упуская возможность повысить вовлеченность аудитории.

Существующий сценарный бот не понимал сложные запросы, не поддерживал контекст диалога и не давал ответы не по сценарию. Это создавало "тупики" в общении, заставляло пользователей уходить с сайта или дублировать вопрос живому менеджеру, сводя на нет пользу от автоматизации.

Андрей Журавлев, fullstack-разработчик Maxed.pro

Цели и задачи

Заказчик поставил перед нами четкую задачу — совершить технологический скачок.

Ключевые цели проекта:

- Снизить нагрузку на консультантов, автоматизировав ответы на 90% типовых вопросов.

- Повысить качество и скорость ответов для пользователей сайта, обеспечив поддержку в режиме 24/7.

- Увеличить вовлеченность пользователей за счет проактивных и релевантных предложений услуг Заказчика.

- Создать интеллектуального помощника, способного понимать естественную речь и поддерживать осмысленный диалог.

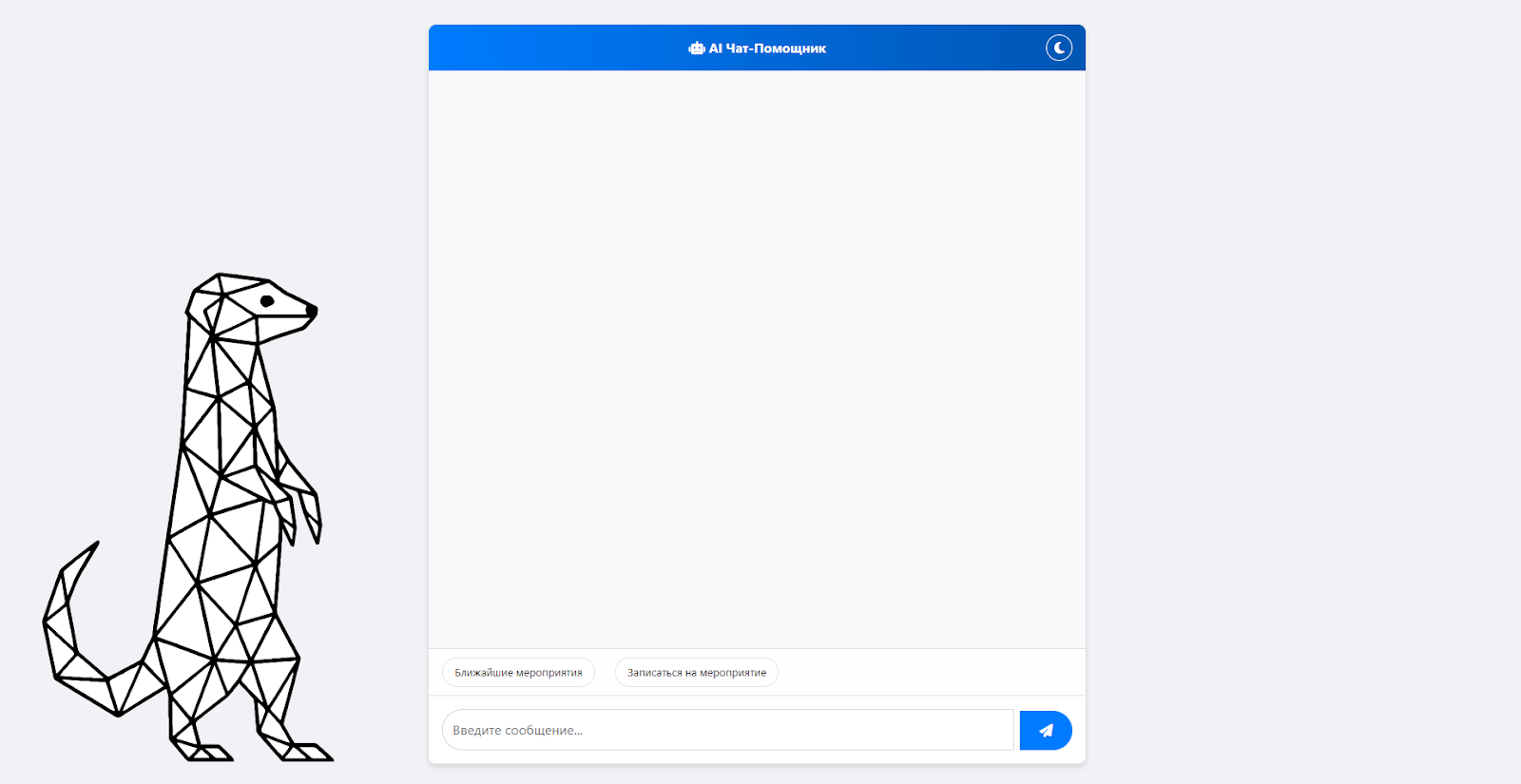

Решение: Управляемый AI на базе LLM и RAG

Просто "подключить ChatGPT" к сайту — быстрый путь к катастрофе: бот будет выдумывать факты, советовать несуществующие услуги и наносить репутационный ущерб. Нашей задачей было создать надежную, управляемую и безопасную систему. Мы спроектировали многоуровневую архитектуру на фреймворке Neuron AI.

1. Интеллектуальное ядро (LLM). В основе бота лежит большая языковая модель (LLM), которая отвечает за понимание естественной речи пользователя: с опечатками, сложными формулировками и уточняющими вопросами.

2. База знаний с технологией RAG (Retrieval-Augmented Generation). Это ключевой элемент, который отличает нашего бота от "фантазера". Мы внедрили технологию RAG.

- Как это работает: Прежде чем сгенерировать ответ, LLM обращается к заранее подготовленной и верифицированной базе знаний (документы, инструкции, страницы сайта Заказчика). Бот находит релевантные фрагменты информации и строит ответ строго на их основе. Он не придумывает, а цитирует первоисточник, как идеальный консультант.

- Оркестратор: задача — проанализировать запрос пользователя и понять истинное намерение (например, "хочет узнать о ближайшем вебинаре" или "ищет условия микрозайма");

- Агент-Ответчик: получив задачу от Оркестратора, обращается к базе знаний и формирует наиболее полный, структурированный и полезный ответ.

Изначально мы планировали автоматически загрузить в базу знаний весь сайт. Но быстро поняли, что это создаст много "шума". Для MVP мы приняли стратегическое решение: подготовить контент вручную по самым востребованным темам — мероприятиям и консультациям. Да, это дольше. Но позволило добиться максимальной точности ответов на старте.

Андрей Журавлев, fullstack-разработчик Maxed.pro

Процесс и сроки

- Сроки: 3 месяца

- Проектирование архитектуры: Выбор LLM, проектирование RAG-системы и логики агентов на платформе Neuron AI.

- Подготовка базы знаний: Ручной сбор, структурирование и загрузка информации по ключевым услугам Заказчика.

- Итеративная настройка промптов: Это была одна из самых сложных задач. Мы провели несколько циклов тестирования, чтобы "научить" бота общаться в нужном тоне — официально, но дружелюбно, — и корректно выполнять свои функции.

- Разработка и демонстрация MVP: Создание рабочего прототипа, который наглядно показал клиенту возможности новой системы.

| Показатель | Было (старый бот) | Стало (новый бот) | |

| Способ взаимодействия | Жесткие сценарии, клики по кнопкам | Естественный диалог, понимание живой речи | |

| Качество ответов | Ответы только на стандартные вопросы. Частые "тупики" | Точные, развернутые ответы на сложные вопросы на основе базы знаний | |

| Доступность поддержки | 24/7, но с крайне ограниченным функционалом | Полноценная круглосуточная консультация по ключевым темам | |

| Вовлечение | Нулевое. Бот не мог ничего предложить | Проактивные предложения релевантных услуг и мероприятий в ходе диалога |

Результаты: От рутины к полной автоматизации

Главный итог проекта — процесс получения, проверки и обновления данных о контрагентах полностью автоматизирован.

Ключевой задачей модуля была онлайн-проверка доступности услуги по статусам клиента: ОПФ, НПД, СМСП, регион и т.д. Результат достигнут: модуль позволяет определить доступность услуги в момент обращения клиента

Прогнозные результаты после полного внедрения:

- снижение количества обращений к живым консультантам по типовым вопросам на 40-60%;

- увеличение конверсии в заявки на услуги Заказчика через сайт;

- рост индекса удовлетворенности пользователей (CSAT) от взаимодействия с сайтом;

- среднее время получения ответа на вопрос сократится с нескольких часов (ожидание ответа оператора) до нескольких секунд.

Ключевые выводы

- Будущее за управляемыми AI-системами: Успех LLM-бота зависит не от мощности модели, а от качества архитектуры вокруг нее, в первую очередь — от RAG и грамотного промпт-инжиниринга.

- Качество данных решает все: "Мусор на входе — мусор на выходе". Инвестиции в создание чистой и структурированной базы знаний — залог точности и надежности AI-ассистента.

- Итеративный подход — ключ к успеху: Невозможно с первого раза написать идеальный промпт. Только циклы тестирования и доработки позволяют "настроить" голос и поведение бота.

- Сценарные боты мертвы: Для компаний со сложными услугами и большой базой знаний переход на диалоговый AI — это уже не инновация, а необходимое условие для выживания в конкурентной среде.

Ваш чат-бот все еще заставляет клиентов ходить по кругу?

Расскажем, как создать интеллектуального AI-ассистента, который будет решать проблемы пользователей, а не создавать новые.

Свяжитесь с нами для демонстрации. Заполните форму ниже.

— Бесплатные Сайты и CRM.

— Бесплатные Сайты и CRM.